혼자 보려고 기록하는 것! 짧은 시간안에 정확하게 내용을 파악할 수 있길 바라며✨

🙌 gMLP를 제안함

transformer를 상대할 수 있는 새로운 구조를 선보임. attention mechanism은 dynamic parameterized가 필요하고, MLP는 static parameterization으로 표현할 수 있음.

SGU와 [ ]의 비교

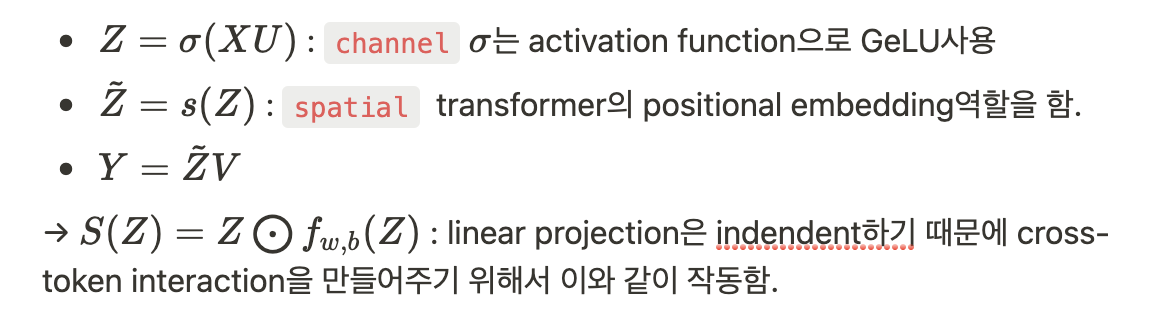

- SGU는 GLU와 전반적으로 닮았지만, spatial(cross-token)상에 projection이 이루어진다. cf. GLU는 channel dimension(hidden)상

- element-wise multiplication : Squeeze-and-Excite block과 관련되어 있다. SGU는 cross-channel projection을 전혀 포함하지 않고 있고 static parameterization 때문에 permutation invariance의 문제도 걱정할 필요가 없음.

- spatial projection

- superficial depth-wise convolutions(채널간에 공유되는 단일 변환 )

- high-order relationships

- 2nd-order interactions (e.g., zizj ) - self-attention은 3rd-order

- computational : multiply-add가 dot-product(self-attention)보다 나음

- 그리고, SGU는 positional encoding을 쓰지 않아도 된다는 장점이 있다!!

conclusion

- pre-training : perplexity를 비교하면 MLP-MIXER 보다는 훨 좋은 결과를 보이고 BERT만큼의 perplexity를 보인다.

- fine-tuning : SQUAD에서 self-attention없이도 괜찮은 결과가 나왔다.

- 모델사이즈가 커질수록 transformer보다 더 좋은 성능을 보이고 있다. (perplexity-parameter의 관계 : parameter가 많아질수록 perplexity는 좋아짐. 다른 모델들에도 적용가능한 법칙)

- 트랜스포머가 이렇게 효과적인 이유는 feedforward의 성질 때문일까? 멀티헤드 셀프어텐션 덕분일까? → 트랜스포머의 multi-head self-attention이 다운스트림 태스크에서 유용한 역할을 한다는 것을 알게 되었다. (cross-sentence alignment)

- 모델의 크기를 키우는 것 대신에 a small single-head self-attention과 gMLP를 블렌드하면 더 좋은 아키텍처로 실용적으로 사용할 수 있다.